在OTT(超越顶层)内容交付和实时通信(RTC)的世界中,媒体播放器在为最终用户提供高质量音频和视频体验方面发挥着至关重要的作用。本文将探讨媒体播放器的内部工作原理,将其过程分解为四个主要步骤:文件获取、音视频分离、解码与同步以及渲染。

1. 文件获取

播放过程的第一步是获取媒体文件。这可以通过两种主要方式进行:

网络下载:文件可以通过RTMP(实时消息传递协议)或HTTP(超文本传输协议)等协议从远程服务器下载。

本地访问:文件可以通过I/O协议从本地磁盘访问,通常通过file://协议进行。

一旦播放器获得了文件,它会解析容器格式以了解内容是如何打包的。

2. 音视频分离

获取文件后,播放器需要分离媒体的不同组成部分。这个过程包括:

元数据解析:播放器分析文件的元数据,以收集有关内容的信息。

流分离:内容被分成多个独立的流,这些流可能包括:

- 视频流

- 音频流

- 字幕

- 章节信息

这种分离是由一个称为分离器或解复用器的模块执行。它通常不是计算密集型的,因为它主要涉及数据的收集、分割和选择。

3. 解码与同步

一旦流被分离,就需要进行解码和同步。这个过程对于确保无缝的观看体验至关重要。

解码

不同的流被发送到各自的解码器:

- H.264视频流送入视频解码器

- AAC音频流送入音频解码器

每个解码器将编码的数据解压缩回其原始格式。

同步挑战

解码后,我们面临一个关键问题:如何确保分别解码的音频和视频流完美同步?

这就是DTS(解码时间戳)和PTS(呈现时间戳)发挥作用的地方。这些时间戳对于解决音频和视频数据之间的同步问题至关重要,并且帮助防止解码器输入缓冲区溢出或不足。

- DTS(解码时间戳):指示何时将数据输入解码器。

- PTS(呈现时间戳):指示何时显示解码后的帧。

DTS和PTS可以是相对时间,在大多数情况下,它们是相同的。

视频同步

对于视频,每个I、P和B帧都携带DTS和PTS。这是必要的,因为帧的存储顺序通常与其显示顺序不同。例如,存储顺序可能是IPBBBBB...,而显示顺序是IBBBBBP.... 在显示之前,需要对解码器缓冲区中的帧进行重新排序,而PTS在此过程中至关重要。

音频同步

音频数据也具有帧的概念,尽管这些是人为定义的。通常,选择一定数量的连续样本作为音频帧,并为该帧添加一个PTS。对于AAC,通常有1024个连续样本形成一个帧。在48000Hz的采样率下,每个音频帧大约为21.33毫秒(1024×1000÷48000)。

同步过程

在大多数情况下,由于音频的固定采样率,音频帧的PTS相对稳定。因此,在显示时,我们使用音频帧的PTS作为时间参考。当解码和显示一个音频帧时,我们寻找具有接近PTS的视频帧以同时显示,从而实现音视频同步。

需要注意的是,对于音频和视频帧,精确匹配的PTS值是具有挑战性的。一般来说,如果音频和视频的PTS值之间的差异在200毫秒以内,我们认为它们是同步的。

故障排除同步问题

如果PTS差异很小,但画面和声音仍然不匹配,通常表明在捕获过程中存在问题。

通过理解和正确实施这些同步技术,开发人员可以确保OTT和RTC应用程序为最终用户提供高质量、同步的音视频体验。

4. 渲染与显示

最后一步是渲染解码后的内容:

视频渲染

解码后的视频帧包含每个像素的颜色值,发送到渲染器以在屏幕上显示。

音频渲染

解码后的音频数据以波形的形式发送到声卡,然后播放到扬声器。

操作系统通常提供用于渲染的API:

- Windows:DirectX

- Android:OpenGL ES(视频)和OpenSL ES(音频)

- iOS:OpenGL ES(视频)和AudioUnit(音频)

虽然开发者可以实现自定义渲染,但由于复杂性,通常不推荐这样做。

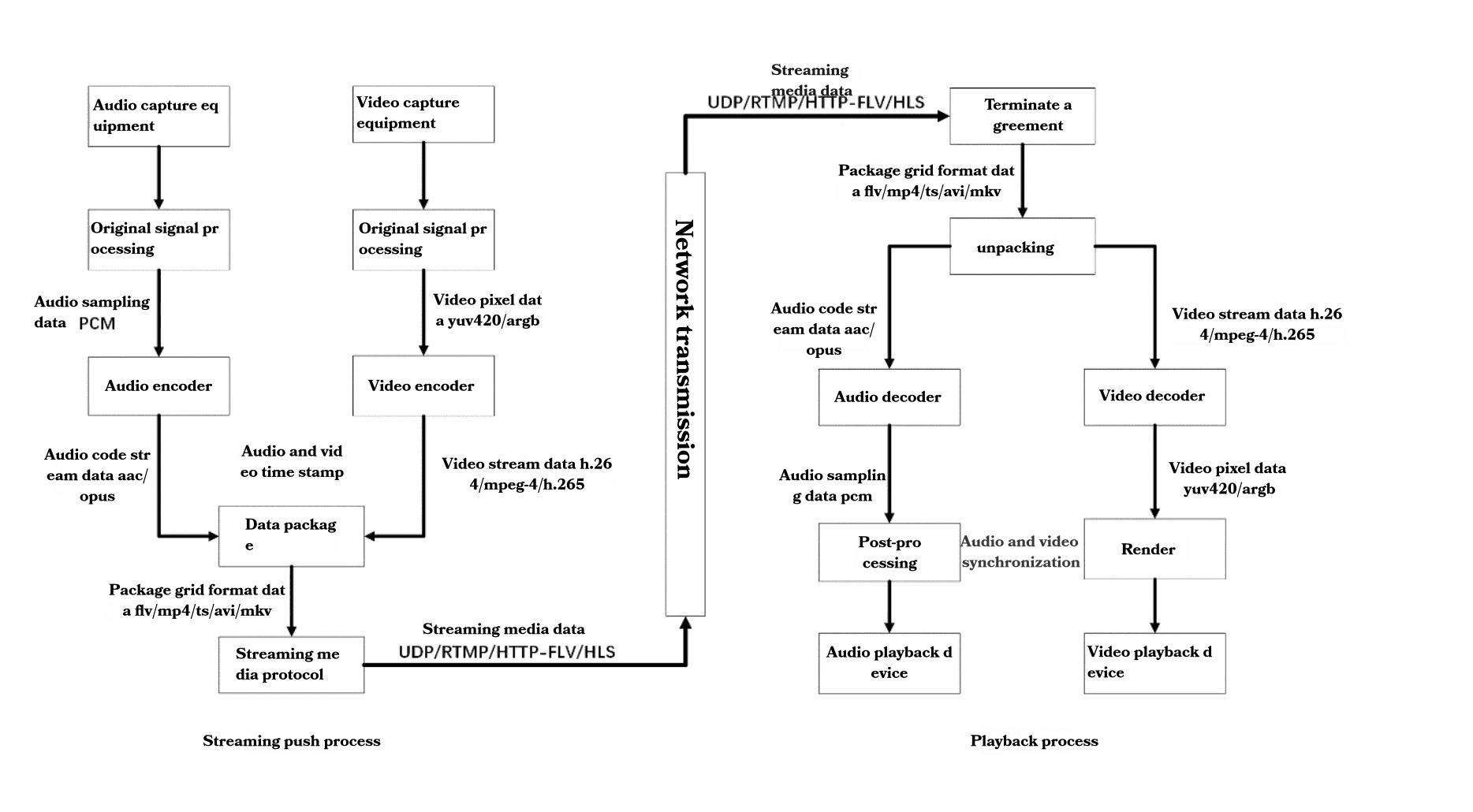

完整的音视频流程

为了更好地理解整个过程,让我们回顾一下音视频流程:

捕获:

- 通过麦克风捕获音频

- 通过摄像头捕获视频

处理:

- 原始音频数据(PCM)被处理

- 原始视频数据(YUV420/ARGB)被处理

编码:

- 音频编码为AAC/Opus等格式

- 视频编码为H.264/MPEG-4/H.265等格式

打包:

- 编码流被打包到FLV/MP4/TS/AVI/MKV等容器中

传输:

- 打包数据通过UDP/RTMP/HTTP-FLV/HLS等协议进行传输

接收与解包:

- 接收到的数据被解包

解码:

- 音频和视频流被解码回PCM和YUV420/ARGB格式

后处理与同步:

- 解码后的流被处理和同步

渲染:

- 音频通过音频播放设备播放

- 视频在视频显示设备上显示

结论

理解媒体播放器的复杂性对于从事OTT和RTC技术的开发人员至关重要。从文件获取到渲染,每个步骤在提供无缝的观看体验中都扮演着重要角色。随着技术的不断发展,跟上这些过程的最新动态将是开发高效、高质量媒体应用程序的关键。