OTT(オーバー・ザ・トップ)コンテンツ配信とリアルタイムコミュニケーション(RTC)の世界では、メディアプレーヤーはエンドユーザーに高品質のオーディオおよびビデオ体験を提供する上で重要な役割を果たします。このブログ記事では、メディアプレーヤーの内部動作を探求し、そのプロセスを4つの主要なステップに分解します:ファイル取得、音声と映像の分離、デコードと同期、レンダリング。

1. ファイル取得

再生プロセスの最初のステップは、メディアファイルを取得することです。これは主に2つの方法で行われます:

ネットワークダウンロード:ファイルはRTMP(リアルタイムメッセージングプロトコル)やHTTP(ハイパーテキスト転送プロトコル)などのプロトコルを使用してリモートサーバーからダウンロードできます。

ローカルアクセス:ファイルは通常file://プロトコルを介してローカルディスクからアクセスできます。

プレーヤーがファイルを取得すると、コンテナフォーマットを解析してコンテンツがどのようにパッケージ化されているかを理解します。

2. 音声と映像の分離

ファイルを取得した後、プレーヤーはメディアの異なるコンポーネントを分離する必要があります。このプロセスには次のことが含まれます:

メタデータ解析:プレーヤーはファイルのメタデータを分析してコンテンツに関する情報を収集します。

ストリーム分離:コンテンツは次のような別々のストリームに分割されます:

- ビデオストリーム

- オーディオストリーム

- 字幕

- チャプター情報

この分離は、スプリッターまたはデマルクサーと呼ばれるモジュールによって実行されます。これは、主にデータを収集、分割、および選択することを含むため、計算負荷は一般的にそれほど高くありません。

3. デコードと同期

ストリームが分離された後、それらはデコードされ、同期される必要があります。このプロセスは、シームレスな視聴体験を保証するために重要です。

デコード

異なるストリームは、それぞれのデコーダに送信されます:

- H.264ビデオストリームはビデオデコーダに送信されます

- AACオーディオストリームはオーディオデコーダに送信されます

各デコーダは、エンコードされたデータを元の形式に戻します。

同期の課題

デコード後、私たちは重要な質問に直面します:どのようにして分離されたデコードされたオーディオとビデオストリームを完全に同期させることができるのでしょうか?

ここでDTS(デコーダタイムスタンプ)とPTS(プレゼンテーションタイムスタンプ)が登場します。これらのタイムスタンプは、オーディオとビデオデータ間の同期問題を解決するために重要であり、デコーダ入力バッファのオーバーフローやアンダーフローを防ぐのに役立ちます。

- DTS(デコーダタイムスタンプ):データをデコーダに供給するタイミングを示します。

- PTS(プレゼンテーションタイムスタンプ):デコードされたフレームを表示するタイミングを示します。

DTSとPTSは相対的な時間である場合が多く、ほとんどの場合、同一です。

ビデオの同期

ビデオの場合、各I、P、およびBフレームにはDTSとPTSの両方が含まれています。これは、フレームの保存順序が表示順序と異なることが多いためです。たとえば、保存順序がIPBBBBB...であるのに対し、表示順序はIBBBBBP...です。表示前に、デコーダのバッファ内のフレームを再整理する必要があり、このプロセスにはPTSが不可欠です。

オーディオの同期

オーディオデータにもフレームの概念がありますが、これは人工的に定義されています。通常、一連の連続したサンプルがオーディオフレームとして選ばれ、そのフレームにPTSが追加されます。AACの場合、通常1024の連続したサンプルが1フレームを形成します。サンプリングレートが48000Hzの場合、各オーディオフレームは約21.33ms(1024×1000÷48000)です。

同期プロセス

ほとんどの場合、オーディオの固定サンプリングレートのため、オーディオフレームのPTSは比較的安定しています。したがって、表示する際にはオーディオフレームのPTSを時間の基準として使用します。オーディオフレームをデコードして表示する際には、同時に表示するために近いPTSのビデオフレームを探します。これにより、オーディオとビデオの同期が達成されます。

オーディオとビデオのフレームのPTS値が正確に一致することは難しいことに注意が必要です。一般的に、PTS値の差が200ms以内であれば、オーディオとビデオは同期していると見なします。

同期の問題のトラブルシューティング

PTSの差が小さいが、画像と音声が一致しない場合、これは通常、キャプチャプロセス中に問題が発生したことを示しています。

これらの同期技術を理解し、適切に実装することで、開発者はOTTおよびRTCアプリケーションがエンドユーザーに高品質で同期されたオーディオビデオ体験を提供することを確保できます。

4. レンダリングと表示

最後のステップは、デコードされたコンテンツのレンダリングです:

ビデオレンダリング

デコードされたビデオフレームは、各ピクセルの色値を含み、画面に表示するためにレンダラーに送信されます。

オーディオレンダリング

デコードされたオーディオデータは波形の形でサウンドカードに送信され、スピーカーで再生されます。

オペレーティングシステムは、レンダリングのためのAPIを通常提供しています:

- Windows:DirectX

- Android:OpenGL ES(ビデオ)およびOpenSL ES(オーディオ)

- iOS:OpenGL ES(ビデオ)およびAudioUnit(オーディオ)

開発者はカスタムレンダリングを実装できますが、通常はその複雑さのため推奨されません。

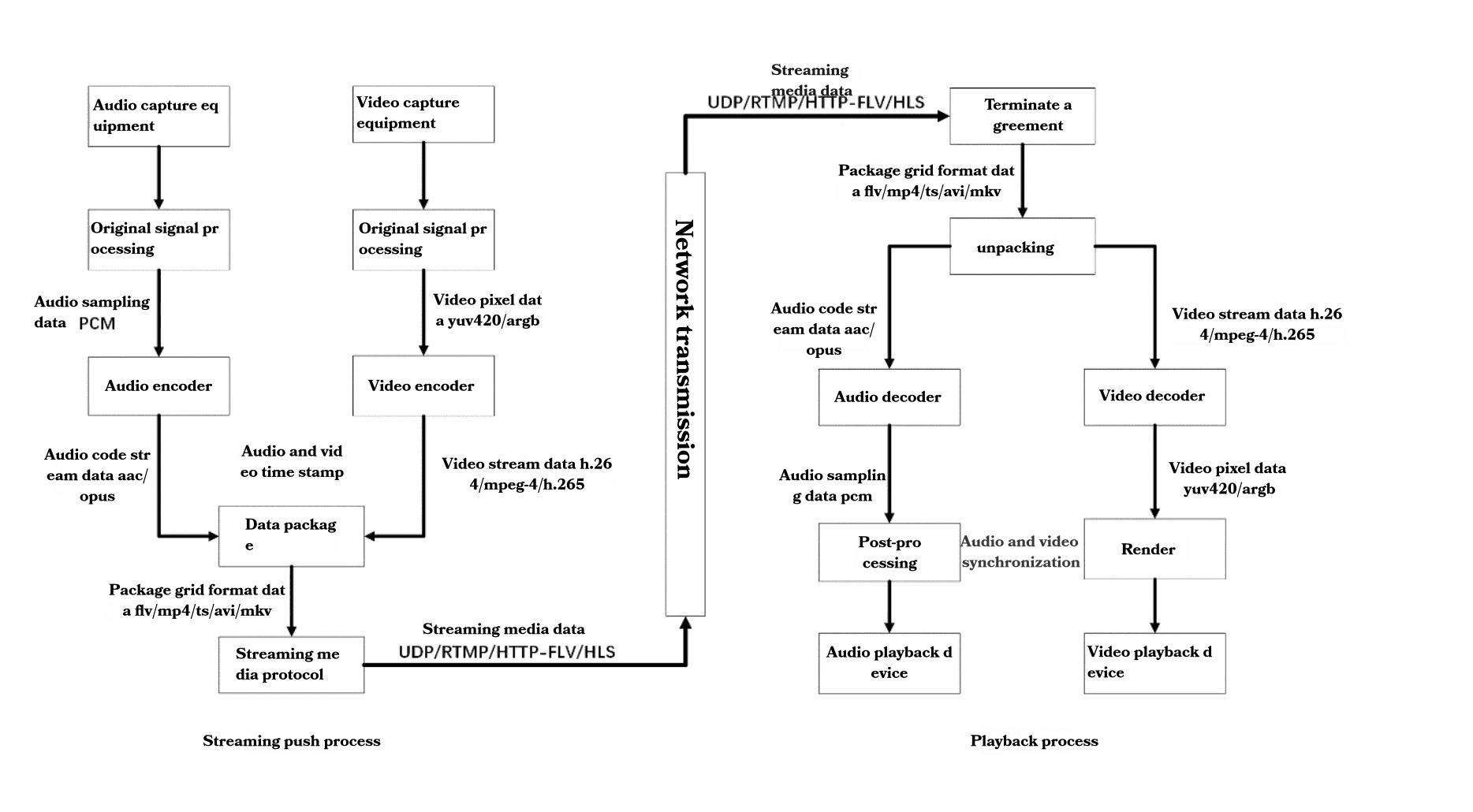

完全なオーディオビデオフロー

全体のプロセスをよりよく理解するために、オーディオビデオフローを確認しましょう:

キャプチャ:

- マイクロフォンによってキャプチャされた音声

- カメラによってキャプチャされた映像

処理:

- 生オーディオデータ(PCM)が処理されます

- 生ビデオデータ(YUV420/ARGB)が処理されます

エンコーディング:

- オーディオはAAC/Opusなどのフォーマットにエンコードされます

- ビデオはH.264/MPEG-4/H.265などのフォーマットにエンコードされます

パッケージング:

- エンコードされたストリームがFLV/MP4/TS/AVI/MKVなどのコンテナにパッケージ化されます

伝送:

- パッケージ化されたデータはUDP/RTMP/HTTP-FLV/HLSなどのプロトコルを使用して伝送されます

受信とアンパッキング:

- 受信したデータがアンパックされます

デコード:

- オーディオとビデオストリームは、それぞれPCMおよびYUV420/ARGBにデコードされます

後処理と同期:

- デコードされたストリームが処理され、同期されます

レンダリング:

- オーディオはオーディオ再生デバイスを通じて再生されます

- ビデオはビデオ表示デバイスに表示されます

結論

メディアプレーヤーの複雑さを理解することは、OTTおよびRTC技術に携わる開発者にとって重要です。ファイル取得からレンダリングまで、各ステップはシームレスな視聴体験を提供する上で重要な役割を果たします。技術が進化し続ける中、これらのプロセスについて最新の情報を維持することは、高効率で高品質なメディアアプリケーションを開発するための鍵となります。